半导体制程发展史 一看便懂

消息来源:baojiabao.com 作者: 发布时间:2024-04-19

导读:半导体制造工艺节点是如何演进的?晶体管的架构是怎样发展成如今模样的?下面告诉你...

半导体制造的工艺节点,涉及到多方面的问题,如制造工艺和设备,晶体管的架构、材料等。下面,我们就具体介绍并分析一下,供大家参考。

首先,技术节点是什么意思呢?常听说的,诸如,台积电16nm工艺的Nvidia GPU、英特尔14nm工艺的i5,这个长度的含义,具体的定义需要详细给出晶体管的结构图才行,简单地说,在早期,可以认为是晶体管的尺寸。

这个尺寸很重要,因为晶体管的作用,简单地说,就是把电子从一端(S),通过一段沟道,送到另一端(D),这个过程完成之后,信息的传递就完成了。因为电子的速度是有限的,在现代晶体管中,一般都是以饱和速度运行的,所以需要的时间基本就由这个沟道的长度来决定。越短,就越快。

这个沟道的长度,和前面说的晶体管的尺寸,大体上可以认为是一致的。但是二者有区别,沟道长度是一个晶体管物理的概念,而用于技术节点的那个尺寸,是制造工艺的概念,二者相关,但是不能完全划等号。

在微米时代,这个技术节点的数字越小,晶体管的尺寸也越小,沟道长度也就越小。但是在22nm节点之后,晶体管的实际尺寸,或者说沟道的实际长度,是长于这个数字的。比方说,英特尔的14nm的晶体管,沟道长度其实是20nm左右。

这里就涉及到三个问题:

- 第一,为什么要把晶体管的尺寸缩小?以及是按照怎样的比例缩小的?这个问题就是在问,缩小有什么好处?

- 第二, 为什么技术节点的数字不能等同于晶体管的实际尺寸?或者说,在晶体管的实际尺寸并没有按比例缩小的情况下,为什么要宣称是新一代的技术节点?这个问题就是在问,缩小有什么技术困难?

- 第三, 具体如何缩小?也就是,技术节点的发展历程是怎样的?在每一代都有怎样的技术进步?在这里我特指晶体管的设计和材料。

下面尽我所能来回答,欢迎指正。

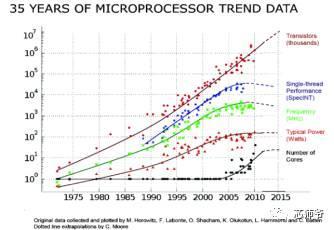

第一个问题,一部分的答案已经说了,因为越小就越快。这个快是可以直接翻译为基于晶体管的集成电路芯片的性能上去的。下面以微处理器CPU为例,如下图所示。

上边这张图的信息量很大,绿色的点,代表CPU的时钟频率,越高当然越快。可以看出直到2004年,CPU的时钟频率基本是指数上升的,背后的主要原因就是晶体管的尺寸缩小。

另外一个重要的原因是,尺寸缩小之后,集成度(单位面积的晶体管数量)提升,这有多个好处,一来可以增加芯片的功能,二来,根据摩尔定律,集成度提升的直接结果是成本的下降。

这也是为什么半导体行业50年来如一日地追求摩尔定律的原因,因为如果达不到这个标准,你家的产品成本就会高于能达到这个标准的对手,你家就倒闭了。

还有一个原因是晶体管缩小可以降低单个晶体管的功耗,因为缩小的规则要求,同时会降低整体芯片的供电电压,进而降低功耗。

但也有例外,从物理原理上说,单位面积的功耗并不降低。因此这成为了晶体管缩小的一个很严重的问题,因为理论上的计算是理想情况,实际上,不仅不降低,反而是随着集成度的提高而提高的。

2000年前后,人们已经预测到,根据摩尔定律的发展,如果没有什么技术进步的话,晶体管缩小到2010年前后时,其功耗密度可以达到火箭发动机的水平,这样的芯片当然是不可能正常工作的。即使达不到这个水平,温度太高也会影响晶体管的性能。

事实上,业界现在也没有找到真正彻底解决晶体管功耗问题的方案,实际的做法是:一方面降低电压(功耗与电压的平方成正比),一方面不再追求时钟频率。因此在上图中,2005年以后,CPU频率不再增长,性能的提升主要依靠多核架构。这个被称作“功耗墙”,至今仍然存在,所以你买不到5GHz的处理器,4G的都几乎没有。

以上是三个缩小晶体管的主要诱因。可以看出,都是重量级的提升性能、功能、降低成本的方法,所以业界才会一直坚持到现在。

那么是怎样缩小的呢?物理原理是恒定电场,因为晶体管的物理学通俗的说,是电场决定的,所以只要电场不变,晶体管的模型就不需要改变,这种方式被证明效果最佳,被称为Dennard Scaling,提出者是IBM。

电场等于电压除以尺寸。既然要缩小尺寸,就要等比降低电压。

如何缩小尺寸?简单粗暴:将面积缩小到原来的一半就好了。面积等于尺寸的平方,因此尺寸就缩小大约0.7。如果看一下晶体管技术节点的数字:

130nm 90nm 65nm 45nm 32nm 22nm 14nm 10nm 7nm (5nm)

会发现是一个大约以0.7为比的等比数列。现在,这只是一个命名的习惯,跟实际尺寸已经有差距了。

第二个问题,为什么现在的技术节点不再直接反应晶体管的尺寸呢?

原因也很简单,因为无法做到这个程度的缩小了。有三个主要原因:

首先,原子尺度的计量单位是埃,为0.1nm。

10nm的沟道长度,也就只有不到100个硅原子而已。未来晶体管物理模型是这样的:用量子力学的能带论计算电子的分布,但是用经典的电流理论计算电子的输运。

电子在分布确定之后,仍然被当作一个粒子来对待,而不是考虑它的量子效应。因为尺寸大,所以不需要。但是越小,就越不行,就需要考虑各种复杂的物理效应。

其次,即使用经典的模型,性能上也出了问题,这个叫做短沟道效应,其效果是损害晶体管的性能。

短沟道效应其实很好理解,通俗地讲,晶体管是一个三个埠的开关,其工作原理是把电子从一端(源端)送到另一端(漏端),这是通过沟道进行的,另外还有一个埠(栅端)的作用是,决定这条沟道是打开的,还是关闭的。这些操作都是通过在埠上加上特定的电压来完成的。

晶体管性能依赖的一点是,必须要打得开,也要关得紧。短沟道器件,打得开没问题,但是关不紧,原因就是尺寸太小,内部有很多电场上的互相干扰,以前都是可以忽略不计的,现在则会导致栅端的电场不能够发挥全部的作用,因此关不紧。关不紧的后果就是有漏电流,简单地说就是不需要、浪费的电流。

可不能小看这部分电流,因为此时晶体管是在休息,没有做任何事情,却在白白地耗电。目前,集成电路中的这部分漏电流导致的能耗,已经占到了总能耗的近50%,所以也是目前晶体管设计和电路设计的一个最主要的难题。

第三,制造工艺也越来越难做到那么小的尺寸了。

决定制造工艺的最小尺寸的,叫做光刻机。它的功能是,把预先印制好的电路设计,像洗照片一样洗到芯片表面上去,在我看来就是一种bug级的存在,因为吞吐率非常地高。否则那么复杂的集成电路,如何才能制造出来呢?比如英特尔的奔腾4处理器,据说需要30~40多张不同的设计模板,先后不断地曝光,才能完成整个处理器的设计印制。

但是光刻机,顾名思义,是用光的,当然不是可见光,但总之是光。

而稍有常识就会知道,所有用光的东西,都有一个问题,就是衍射。光刻机也不例外。

因为这个问题的制约,任何一台光刻机所能刻制的最小尺寸,基本上与它所用的光源的波长成正比。波长越小,尺寸也就越小,这个道理是很简单的。

目前的主流生产工艺采用荷兰艾斯摩尔生产的步进式光刻机,所使用的光源是193nm的氟化氩(ArF)分子振荡器产生的,被用于最精细尺寸的光刻。

相比之下,目前的最小量产的晶体管尺寸是20nm (14nm node),已经有了10倍以上的差距。

有人会问,为何没有衍射效应呢?

答案是业界10多年来在光刻技术上投入了巨资,先后开发了各种魔改级别的暴力技术,诸如浸入式光刻(把光程放在某种液体里,因为光的折射率更高,而最小尺寸反比于折射率)、相位掩模(通过180度反向的方式来让产生的衍射互相抵消,提高精确度),等等,就这样一直撑到了现在,支持了60nm以来的所有技术节点的进步。

又有人会问,为何不用更小波长的光源呢?

答案是,工艺上暂时做不到。

是的,高端光刻机的光源,是世界级的工业难题。

以上就是目前主流的深紫外曝光技术(DUV)。业界普遍认为,7nm技术节点是它的极限了,甚至7nm都不一定能够做到量产。下一代技术仍然在开发之中,被称为极紫外(EUV),其光源降到了13nm。但是别高兴地太早,因为在这个波长,已经没有合适的介质可以用来折射光,构成必须的光路了,因此这个技术里面的光学设计,全部是反射,而在如此高的精度下,设计如此复杂的反射光路,本身就是难以想像的技术难题。

这还不算(已经能克服了),最难的还是光源,虽然可以产生所需的光线,但是强度远低于工业生产的需求,造成EUV光刻机的晶圆产量达不到要求,换言之,拿来用就会赔本。一台这种机器就上亿美元。所以EUV还属于未来。

基于以上三个原因,其实很早开始就导致晶体管的尺寸缩小进入了深水区,越来越难,到了22nm之后,已经无法做大按比例缩小了,因此就没有再追求一定要缩小,反而是采用了更加优化的晶体管设计,配合CPU架构上的多核多线程等一系列技术,继续为消费者提供相当于更新换代了的产品性能。

目前,技术节点的数字仍然在缩小,但是已然不再等同于晶体管的尺寸,而是代表一系列构成这个技术节点的指标的技术和工艺的总和。

第三个问题,技术节点的缩小过程中,晶体管的设计是怎样发展的。

首先要搞清楚,晶体管设计的思路是什么。主要的无非两点:第一提升开关响应度,第二降低漏电流。

为了讲清楚这个问题,最好的方法是看图。晶体管物理的图,基本上搞清楚一张就足够了,就是漏电流-栅电压的关系图,比如下面这种:

横轴代表栅电压,纵轴代表漏电流,并且纵轴一般是对数坐标。

前面说过,栅电压控制晶体管的开关。可以看出,最好的晶体管,是那种能够在很小的栅电压变化内,一下子就从完全关闭(漏电流为0),变成完全打开(漏电流达到饱和值),也就是虚线。这个性质有多方面的好处,下面会说明。

显然这种晶体管不存在于这个星球上。原因是,在经典的晶体管物理理论下,衡量这个开关响应能力的标准,叫做Subthreshold Swing(SS,不是党卫军...),有一个极限值,约为60,背后的原因就不细说了。

根据英特尔的数据,最新的14nm晶体管,这个数值大概是70左右(越低越好)。

并且,降低这个值,和降低漏电流、提升工作电流(提高速度)、降低功耗等要求,是等同的,因为这个值越低,在同样的电压下,漏电流就越低。而为了达到同样的工作电流,需要的电压就越低,这样等同于降低了功耗。所以说这个值是晶体管设计里面最重要的指标,不过分。

围绕这个指标,以及背后的晶体管性能设计的几个目标,大家都做了哪些事情呢?

先看工业界,毕竟实践是检验真理的唯一标准。下面是我的记忆,和节点的对应不一定完全准确,但具体的描述应该没错:

65nm引入Ge strained沟道。

strain我不知道如何翻译成中文辞汇,但是其原理是通过在适当的地方掺杂一点点的锗到硅里面去,锗和硅的晶格常数不同,因此会导致硅的晶格形状改变,而根据能带论,这个改变可以在沟道的方向上提高电子的迁移率,而迁移率高,就会提高晶体管的工作电流。而在实际中,人们发现,这种方法对于空穴型沟道的晶体管(pmos),比对电子型沟道的晶体管(nmos),更加有效。

45nm引入了高k值绝缘层/金属栅极配置。

这个也是一个里程碑的成果,我在念书的时候曾经有一位帮他搬过砖的教授,当年是在英特尔开发了这项技术的团队的主要成员之一,因此对这一点提的特别多,耳濡目染就记住了。

这是两项技术,但其实都是为了解决同一个问题:即在很小的尺寸下,如何保证栅极有效的工作。

前面没有细说晶体管的结构,下面补一张图:

这是一个最基本的晶体管的结构示意图,现在的晶体管早就不长这样了,但是任何半导体物理都是从这儿开始讲起的,所以这是“标配版”的晶体管,又被称为体硅(bulk)晶体管。

gate就是栅。

其中有一个oxide,绝缘层,前面没有提到,但是却是晶体管所有的构件中,最关键的一个。它的作用是隔绝栅极和沟道。因为栅极开关沟道,是通过电场进行的,电场的产生又是通过在栅极上加一定的电压来实现的,但是欧姆定律告诉我们,有电压就有电流。如果有电流从栅极流进了沟道,那么还谈什么开关?早就漏了。

所以需要绝缘层。为什么叫oxide(or "dielectric")而不叫insulator呢?因为最早的绝缘层就是和硅非常自然地共处的二氧化硅,其相对介电常数(衡量绝缘性的,越高,对晶体管性能来说,越好)约是3.9。一个好的绝缘层是晶体管的生命线,这个“好”的定义在这里不多说了,但是要说明,硅天然就具有这么一个性能:超级好的绝缘层,对于半导体工业来说,是一件有历史意义的事情。

有人曾经感慨,说上帝都在帮助人类发明集成电路,首先给了那么多的沙子(硅晶圆的原料),又给了一个完美的自然绝缘层。所以至今,硅极其难被取代,一个重要原因就是,作为制造晶体管的材料,其综合性能太完美了。

二氧化硅虽好,在尺寸缩小到一定限度时,也出现了问题。别忘了缩小的过程中,电场强度是保持不变的,在这样的情况下,从能带的角度看,因为电子的波动性,如果绝缘层很窄很窄的话,那么有一定的几率电子会发生隧穿效应而越过绝缘层的能带势垒,产生漏电流。

可以想像为穿过一堵比自己高的墙。这个电流的大小和绝缘层的厚度,以及绝缘层的“势垒高度”,成负相关。因此厚度越小,势垒越低,这个漏电流越大,对晶体管越不利。

另一方面,晶体管的开关性能、工作电流等,都需要拥有一个很大的绝缘层电容。实际上,如果这个电容无限大的话,那么就会达到理想化的60的那个SS指标。

这里说的电容都是指单位面积的电容。这个电容等于介电常数除以绝缘层的厚度。显然,厚度越小,介电常数越大,对晶体管越有利。

可以看出,这里已经出现了一对设计目标上的矛盾,那就是绝缘层的厚度要不要继续缩小。实际上在这个节点之前,二氧化硅已经缩小到了不到两个纳米的厚度,也就是十几个原子层的厚度,漏电流的问题已经取代了性能的问题,成为头号大敌。

于是聪明绝顶的人类开始想办法。人类很贪心的,既不愿意放弃大电容的性能增强,又不愿意冒漏电的风险。于是人类说,如果有一种材料,介电常数很高,同时能带势垒也很高,那么是不是就可以在厚度不缩小的情况下(保护漏电流),继续提升电容(提高开关性能)呢?

于是大家就开始找,用几乎暴力的方法,找了许多种奇奇怪怪的材料,终于最后经过验证,确定使用一种名为HfO2的材料。这个元素我以前听都没有听过,中文念什么我都说不上来。就是这么牛。这个就叫做high-k,这里的k是相对介电常数(相对于二氧化硅的而言)。

当然,这个工艺的复杂程度,远远超过这里描述的这么简单。具备high-k性质的材料很多,但是最终被采用的材料,一定要具备许多优秀的电学性质,因为二氧化硅真的是一项非常完美的晶体管绝缘层材料,而且制造工艺流程和集成电路的其它制造步骤可以方便地整合,所以找到这样一项各方面都符合半导体工艺制造的要求的高性能绝缘层材料,是一件了不起的工程成就。

至于金属栅,是与high-k配套的一项技术。在晶体管的最早期,栅极是用铝制作,后来经过发展,改用重掺杂多晶硅制作,因为工艺简单,性能好。到了high-k这里,大家发现,high-k材料有两个副作用,一是会莫名其妙地降低工作电流,二是会改变晶体管的阈值电压。阈值电压就是把晶体管的沟道打开所需要的最小电压值,这个值是非常重要的晶体管参数。

这个原理不细说了(其实是说不清楚才对吧哈哈...?),主要原因是,high-k材料会降低沟内的道载流子迁移率,并且影响在界面上的费米能级的位置。载流子迁移率越低,工作电流就越低,而所谓的费米能级,是从能带论的图像上来解释半导体电子分布的一种分析方法,简单地说,它的位置会影响晶体管的阈值电压。

这两个问题的产生,都和high-k材料内部的偶极子分布有关。偶极子是一端正电荷一端负电荷的一对电荷系统,可以随着外加电场的方向而改变自己的分布,high-k材料的介电常数之所以高的原因,就跟内部的偶极子有很大关系。所以这是一把双刃剑。

于是人类又想,就想到了用金属做栅极,因为金属的自由电荷浓度极高(超过10^20),而且有镜像电荷效应,可以中和掉high-k材料的绝缘层里的偶极子对沟道和费米能级的影响。这样一来就两全其美啦。

至于这种或这几种金属究竟是什么,很抱歉,除了掌握技术的那几家企业之外,外界没有人知道,是商业机密。

有朋友补充说,这种金属是钨,我查阅到资料也提到是钨;钨本身也用在后端的via中; 但是在这个问题上我有些保留,主要原因是4点:

- 第一, 我自己上课的时候,有多位教授都明确提到过,关于这个metal gate的资料外界知之甚少,至少他们自己不知道,或因为某种原因而不愿意说;

- 第二,从原理上说,对于NMOS和PMOS,因为所需的功函数是不一样的,所以单一的一种金属无论如何是不可能满足整个high-k工艺的需求,即使确实是钨,也需要进行work function engineering;

- 第三, 也有很多资料提到了别的材料,譬如说TiN 系列作为metal gate;

- 第四, 或许也是最令人疑惑的,就是在我查阅过的资料中,虽然Intel很早就说使用了HfO2作为high-k材料,但是Intel自己却没有透露这种或这几种金属是什么,譬如它在2008年发表的iedm的文章: http://download.intel.com/pressroom/kits/advancedtech/pdfs/Natarajan_iedm_2008_text.pdf, 没有提及具体的材料,而是以"metal gate"作为代称。Mark Bohl在2007年发表的文章中,也明确说到如下的信息:

“Because the electrical characteristics of the gates of NMOS and PMOS transistors are different, they actually needed not one metal but two—one for NMOS and one for PMOS.”

“But by themselves, none had exactly the work function of the doped silicon, so we had to learn to change the work function of metals to suit our needs.”

“We cannot disclose the exact makeup of our metal layers, because after all, the IC industry is very competitive!”

更新的资料中,似乎也没有找到相关的信息,而是多以WFM (work function metal)作为指代。虽然在研究界有过关于W、TiN等多种材料的不少研究论文发表,但是我自己是无力确认关于这个metal gate材料的信息来源是什么。因为本人并不从事晶体管制造或设计的研究工作,无力回答这个问题。因此希望能有知情的朋友进行补充,并且提供来源。

于是摩尔定律再次胜利。

32nm第二代high-k绝缘层/金属栅工艺。

在45nm时代,英特尔取得了巨大的成功(在很多晶体管、微处理器的发展图上,45nm这一代的晶体管,会在功耗、性能等方面突然出现一个较大的进步折线),32nm时候继续在基础上改换更好的材料,继续了缩小尺寸的老路。当然,前代的Ge strain工艺也是继续使用的。

22nm FinFET(英特尔称为Tri-gate),三栅极晶体管。

这一代的晶体管,在架构上进行了一次变革。变革的最早设计可以追溯到伯克利的胡正明教授2000左右提出的三栅极和环栅晶体管物理模型,后来被英特尔变为了现实。

FinFET 一般模型长这样。它的实质上是增加了一个栅极。

为什么要这么做呢?直观地说,如果看前面的那张“标配版”的晶体管结构图,在尺寸很短的晶体管里面,因为短沟道效应,漏电流是比较严重的。而大部分的漏电流,是通过沟道下方的那片区域流通的。

沟道在图上并没有标出来,是位于氧化绝缘层以下、硅晶圆表面的非常非常薄(一两个纳米)的一个窄窄的薄层。沟道下方的区域被称为耗尽层,就是大部分的蓝色区域。

于是有人就开始想啊,既然电子是在沟道中运动,那么我为何非要在沟道下面留有这么一大片耗尽层呢?当然这是有原因的,因为物理模型需要这片区域来平衡电荷。但是在短沟道器件里面,没有必要把耗尽层和沟道放在一起,等著漏电流白白地流过去。

于是有人(IBM)开了一个脑洞:把这部分硅直接拿掉,换成绝缘层,绝缘层下面才是剩下的硅,这样沟道就和耗尽层分开了,因为电子来源于两极,但是两极和耗尽层之间,被绝缘层隔开了,这样除了沟道之外,就不会漏电啦。比如这样:

这个叫做SOI(绝缘层上硅),虽然没有成为主流,但是因为有其优势,所以现在还有制造厂在搞。

于是有人(英特尔)又想了,既然都是拿掉耗尽层的硅,插入一层氧化层,那么为什么非要放上一堆没用的硅在下面,直接在氧化层底下,再弄一个栅极,两边夹着沟道,岂不是更爽?你看你IBM,就是没雄心。

但是英特尔还觉得不够,又想,既然如此,有什么必要非得把氧化层埋在硅里面?我把硅弄出来,周围三明治一样地包裹上绝缘层,外面再放上栅极,岂不是爽爆?

于是就有了FinFET,上面这种。FinFET牛逼的地方在于,不仅大大降低了漏电流,而且因为多一个栅极,这两个栅极一般都是连在一起的,大大增加了前面说过的那个绝缘层电容,也就大大提升了晶体管的开关性能。所以又是一次革命式的进步。

这个设计其实不难想到,难的是,能够做到。为什么呢?因为竖起来的那一部分硅,也就是用作沟道的硅,太薄了,只有不到10个纳米,不仅远小于晶体管的最小尺寸,也远小于最精密的光刻机所能刻制的最小尺寸。于是如何把这个Fin给弄出来,还得弄好,成了真正的难题。

英特尔的做法是很聪明的,解释起来需要很多张工艺流程图,不多说,但是基本原理是,这部分硅不是光刻出来的,而是长出来的。它先用普通精度的光刻刻出一堆“架子,然后在沉淀一层硅,在架子的边缘就会长出一层很薄的硅,然后再用选择性的刻蚀把多余的材料弄走,剩下的就是这些立着的、超薄的硅Fin了。当时我听说这套方法的时候,彻底跪了,这智商太碾压人了。

FinFET的工艺流程

制作FinFET的工艺流程具体是怎样的呢?笔者并非这方面的专家,所知有限。尽所能查阅了一些资料之后,把相关的一些信息整理在下面,供大家参考。

在2016年8月的这篇访谈中,Intel的Mark Bohl (Senior fellow and director of process architecture and integration)谈到了Intel的FinFET技术,以及对于10nm制程的技术展望。在其中,他提到Intel将会继续使用SADP (Self-Aligned Double Patterning)工艺。

Double Patterning是可以提高光刻最小精度的,是目前主流采用的一种技术,有很多个版本。它的原理是这样的,譬如说,Intel是采用193nm的浸入式光刻来处理最高精度需求的步骤,这个技术的最小尺寸大约是80~90nm之间。如果使用Double Patterning的话呢,则可以将这个精度提高到约40nm左右。

这个在原理上是很容易理解,如果先pattern一批80nm精度的图样,然后再交错著pattern一批80nm精度的图样,在两次光刻之后,图样的精度,以pitch来衡量的话,就会是原来的精度的一半。这个过程在维基百科中就有说明,大家可以直接查阅

Multiple patterning。

Self-Aligned Double Patterning是其中的一种技术,它只需要一次光刻步骤就能完成,而且从原理上说,是可以用来制作fin的(制作fin的这个步骤叫做active fin formation)。我在上一些相关的器件和工艺课程的时候,自己的教授也有提到这个工艺是被用来制作fin的。但是在这方面,我并没有找到直接的资料,来自Intel 或别的几个大厂,来说明自己的active fin formation具体是怎么做的,因此这只能算是一个合理的猜测。

在这个过程中,首先会沉积一层hard mask,又被称作mandral的材料,比如Si3N4之类的。这层材料以普通精度的光刻进行pattern。mandral在被pattern之后,就被称作spacer。然后再生长一层绝缘层材料,譬如二氧化硅,被称作film。

可以通过控制这个生长过程的时间,来控制最终的fin的厚度W。然后对film进行刻蚀,将所有水平方向的材料刻蚀掉,只剩下沿着spacer的边缘所生长出来的那部分,之后再以选择性的刻蚀将spacer材料移除,只剩下这层sidewall film。最后就是对底下的硅材料进行刻蚀,这样相当于用这层film做了mask。

接下来,为了保证isolation,还需要再生长一层绝缘材料二氧化硅,这个步骤要求很高,因为fin和fin之间的那段空间,高宽比是很大的,需要让二氧化硅完全填充这个空隙,所以这个步骤被称作conformal coating。

显然这个步骤之后,硅片的表面是不平整的,因此需要进行一次CMP (Chemical Mechanical Polishing),就是通过添加一定的研磨剂,用机械研磨的方式将整个晶圆的表面给弄平整。

最后就是再对二氧化硅材料进行一次刻蚀,通过控制这次刻蚀的时间,可以控制露出来的fin的高度H。在这个fin上面,再用ALD (Atomic Layer Deposition)等步骤沉积high-k材料等栅极的stack,就基本完成了这部分的制作。

上面这个工艺确实是存在的,也是被采用的,然而关于它有一个问题,就是我所能找到的资料,似乎显示这个工艺是被IBM、三星这系列的厂,用在SOI的finfet上面。

前面提到过SOI的概念,这里应该补充一下,其实SOI和finfet并不是两种对立的技术,之前的比较,只是为了方便从晶体管物理的角度解释两种技术的思路是什么。finfet也是可以制作在SOI晶圆上面的,这是三星它们的做法。

但是Intel似乎并没有采用这种做法,出于成本的考虑(SOI晶圆比较贵),Intel使用的是bulk finfet,沟道底下是没有埋绝缘层的。那么在这个制程下面,active fin formation是否也是用SADP这样的工艺制备的?我没有找到直接的资料证据。

虽然在一些采访和报道中,Intel提到自己是用了SADP工艺,但是这个工艺并不限于制作fin,也可以用在制作栅极的pattern以及后端的via, interconnect上面,因此我不能确定Intel 是怎么做的。

三星在IEDM上发表过他们最新的7nm工艺晶体管的报告中的几张图,概述了三星IBM(这俩是一家人...)这个系列的工艺制程的思路,它们是这样考虑的:

可以看到三星是用SAQP(self-aligned quadruple patterning, 和SADP流程基本一样,而又增加了一次光刻,因此最小尺寸进一步缩小 )来进行7nm fin制备,如下图所示:

它也提到了整个流程,可是我自己完全看不懂@_@

台积电在同一个会议中也发表了7nm,但是语焉不详。Intel则没有发表。在Intel发表的14nm晶体管的文章中,同样只有一句话提到使用了SADP工艺,但是并没有像三星这样细致地说明工艺步骤,而是直接开始讲晶体管的性能,所以在这方面的信息很少。

需要说明一下,无论是哪个工艺,其实一开始都不是这些公司自己发明的,譬如说,胡正明教授就曾经发表过SADP相关的文章,那是早在2006年finfet出来之前多年。

这些公司看重了某个工艺的前景(能不能scale,成本问题,等等),然后将它整合到自己积累多年的制作流程中去,推出新一个节点的制程。因为完成一个工艺的设备成本是极其高昂的,所以往往需要提前多年就做好规划。

14nm 继续FinFET。下面是英特尔的14nm晶体管的SEM横截面图,大家感受一下,fin的宽度平均只有9nm。

当然,在所有后代的技术节点中,前代的技术也是继续整合采用的。所以现在,在业界和研究界,一般听到的晶体管,都被称作high-k/metal gate Ge-strained 14 nm FinFET,整合了多年的技术精华。

而在学术界,近些年陆续搞出了各种异想天开的新设计,比如隧穿晶体管,负电容效应晶体管,碳纳米管,等等。

所有这些设计,基本是4个方向:材料、机理、工艺、结构。而所有的设计方案,其实可以用一条简单的思路概括,就是前面提到的那个SS值的决定公式,里面有两项相乘组成:

因此,要么改善晶体管的静电物理(electrostatics),这是其中一项,要么改善沟道的输运性质(transport),这是另一项。

而晶体管设计里面,除了考虑开关性能之外,还需要考虑另一个性能,就是饱和电流问题。很多人对这个问题有误解,以为饱不饱和不重要,其实电流能饱和才是晶体管能够有效工作的根本原因,因为不饱和的话,晶体管就不能保持信号的传递,因此无法携带负载,换言之只中看,不中用,放到电路里面去,根本不能正常工作的。

举个例子,有段时间石墨烯晶体管很火,石墨烯作沟道的思路是第二项,就是输运,因为石墨烯的电子迁移率远远地完爆硅。但直到目前,石墨烯晶体管还没有太多的进展,因为石墨烯有个硬伤,就是不能饱和电流。但是,去年貌似听说有人能做到调控石墨烯的能带间隙打开到关闭,石墨烯不再仅仅是零带隙,想来这或许会在晶体管材料方面产生积极的影响。

在去年的IEDM会议上,台积电已经领先英特尔,发布了7nm技术节点的晶体管样品,而英特尔已经推迟了10nm的发布。当然,两者的技术节点的标准不一样,台积电的7nm其实相当于英特尔的10nm,但是台积电率先拿出了成品。三星貌似也在会上发表了自己的7nm产品。

可以看出,摩尔定律确实放缓了,22nm是在2010左右出来的,到了现在,技术节点并没有进步到10nm以下。去年,ITRS已经宣布不再制定新的技术路线图,换言之,权威的国际半导体机构已经不认为,摩尔定律的缩小可以继续下去了。

这就是技术节点的主要现状。

技术节点不能进步,是不是一定就是坏事?其实不一定。28nm这个节点,其实不属于前面提到的标准的dennard scaling的一部分,但是这个技术节点,直到现在,仍然在半导体制造业界占据了很大的一块市场份额。

台积电、中芯国际等这样的大代工厂,都是在28nm上玩得很转的。为何呢?因为这个节点被证明是一个在成本、性能、需求等多方面达到了比较优化的组合的一个节点,很多芯片产品,并不需要使用过于昂贵的FinFET技术,28nm能够满足自己的需求。

但是有一些产品,比如主流的CPU、GPU、FPGA、memory,其性能的提升有相当一部分来自于工艺的进步。所以再往后如何继续提升这些产品的性能,是很多人心中的问号,也是新的机会。

内容转自微信,仅作知识分享。

相关文章

中兴受美国制裁事件 被罚了20亿美元过程事件始末 中兴被制裁后公司现状

中兴受美国制裁事件 被罚了20亿美元过程事件始末 中兴被制裁后公司现状2023-11-02 22:12:46

B站怎么炸崩了哔哩哔哩服务器今日怎么又炸挂了?技术团队公开早先原因

B站怎么炸崩了哔哩哔哩服务器今日怎么又炸挂了?技术团队公开早先原因2023-03-06 19:05:55

苹果iPhoneXS/XR手机电池容量续航最强?答案揭晓

苹果iPhoneXS/XR手机电池容量续航最强?答案揭晓2023-02-19 15:09:54

华为荣耀两款机型起内讧:荣耀Play官方价格同价同配该如何选?

华为荣耀两款机型起内讧:荣耀Play官方价格同价同配该如何选?2023-02-17 23:21:27

google谷歌原生系统Pixel3 XL/4/5/6 pro手机价格:刘海屏设计顶配版曾卖6900元

google谷歌原生系统Pixel3 XL/4/5/6 pro手机价格:刘海屏设计顶配版曾卖6900元2023-02-17 18:58:09

科大讯飞同传同声翻译软件造假 浮夸不能只罚酒三杯

科大讯飞同传同声翻译软件造假 浮夸不能只罚酒三杯2023-02-17 18:46:15

华为mate20pro系列手机首发上市日期价格,屏幕和电池参数配置对比

华为mate20pro系列手机首发上市日期价格,屏幕和电池参数配置对比2023-02-17 18:42:49

小米MAX4手机上市日期首发价格 骁龙720打造大屏标准

小米MAX4手机上市日期首发价格 骁龙720打造大屏标准2023-02-17 18:37:22

武汉弘芯遣散!结局是总投资1280亿项目烂尾 光刻机抵押换钱

武汉弘芯遣散!结局是总投资1280亿项目烂尾 光刻机抵押换钱2023-02-16 15:53:18

谷歌GoogleDrive网云盘下载改名“GoogleOne” 容量提升价格优惠

谷歌GoogleDrive网云盘下载改名“GoogleOne” 容量提升价格优惠2023-02-16 13:34:45

巴斯夫将裁员6000人 众化工巨头裁员潮再度引发关注

巴斯夫将裁员6000人 众化工巨头裁员潮再度引发关注2023-02-13 16:49:06

人手不足 韵达快递客服回应大量包裹派送异常没有收到

人手不足 韵达快递客服回应大量包裹派送异常没有收到2023-02-07 15:25:20

资本微念与李子柒销声匿迹谁赢? 微念公司退出子柒文化股东

资本微念与李子柒销声匿迹谁赢? 微念公司退出子柒文化股东2023-02-02 09:24:38

三星GalaxyS8 S9 S10系统恢复出厂设置一直卡在正在检查更新怎么办

三星GalaxyS8 S9 S10系统恢复出厂设置一直卡在正在检查更新怎么办2023-01-24 10:10:02

华为Mate50 RS保时捷最新款顶级手机2022多少钱?1.2万元售价外观图片吊打iPhone14

华为Mate50 RS保时捷最新款顶级手机2022多少钱?1.2万元售价外观图片吊打iPhone142023-01-06 20:27:09

芯片常见的CPU芯片封装方式 QFP和QFN封装的区别?

芯片常见的CPU芯片封装方式 QFP和QFN封装的区别?2022-12-02 17:25:17

华为暂缓招聘停止社招了吗?官方回应来了

华为暂缓招聘停止社招了吗?官方回应来了2022-11-19 11:53:50

热血江湖手游:长枪铁甲 刚猛热血 正派枪客全攻略技能介绍大全

热血江湖手游:长枪铁甲 刚猛热血 正派枪客全攻略技能介绍大全2022-11-16 16:59:09

东京把玩了尼康微单相机Z7 尼康Z7现在卖多少钱?

东京把玩了尼康微单相机Z7 尼康Z7现在卖多少钱?2022-10-22 15:21:55

苹果iPhone手机灵动岛大热:安卓灵动岛App应用下载安装量超100万次

苹果iPhone手机灵动岛大热:安卓灵动岛App应用下载安装量超100万次2022-10-03 22:13:45