AVA数据研究目的,主要是为了让人工智能更能理解人类互动行为,借此提升行为预测能力,进而可用于内容判断等动态影片分析应用,例如监视系统、内容推荐,或是广告媒合推荐等。

在近期研究项目中,Google开始借由旗下YouTube影片内容让人工智能开始学习人类自然互动间所产生肢体动作,借此理解人类自然互动行为模式。

根据Google方面表示,借由名为AVA (atomic visual actions)的原子视觉化动作数据学习模式,让人工智能系统能进一步学习、理解人类自然互动中所呈现动作行为,例如行走、拥抱或握手时所产生自然动作表现。

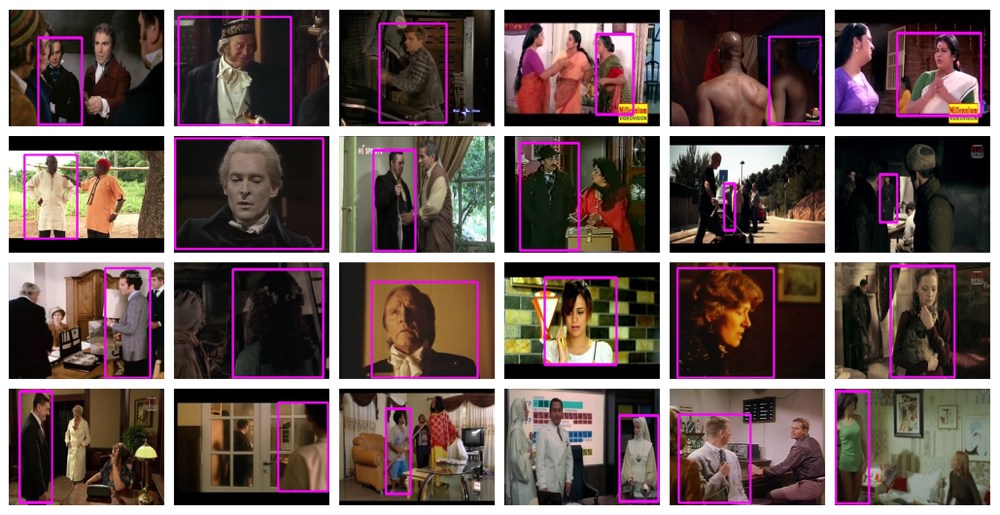

而数据取样来源则是以YouTube收录大量影片内容为主,并且逐一撷取有人类互动行为的15分钟片段,在进一步将15分钟影片长度均分为300组不重复的3秒长度片段,同时将影片中人类互动行为模式各下注记,标示每一种互动行为所代表含意,进而让人工智能进行深度学习。

目前在AVA数据资料中,已将互动行为区分为姿势或移动时的动作表现、人与物品互动行为,以及人与人互动行为三大类型,其中再区分不同细节表现,总计在超过57万组影片内容注记约9万6000组人类行为动作。

为了避免不同地区文化、种族行为差异造成资料误判,Google在AVA数据资料也加入不同地区、不同类型的YouTube影片内容,借此确保全人类行为判断结果的一致性,例如避免产生在认定西方国家常以拥抱作为亲密互动,却因此认为亚洲国家较无亲密互动的情况发生。

AVA数据研究目的,主要是为了让人工智能更能理解人类互动行为,借此提升行为预测能力,进而可用于内容判断等动态影片分析应用,例如监视系统、内容推荐,或是广告媒合推荐等。类似应用,先前NVIDIA也曾借助显卡运算加速模式打造影片内容分析功能,而先前台湾新创团队创意引晴 (Viscovery)也透过视觉分析方式协助影片内容服务厂商优化广告系统。

进一步让人工智能学习人类互动模式,预期将可让电脑系统更容易自主判断,进而可透过电脑视觉方式即时认知人类预期发生行为模式,并且做出更快反应或互动行为,例如未来发展社交机器人的过程,将可让机器人以更自然方式与人互动。

现阶段的人工智能系统已经能将静态影像内容进行相当准确的情境描述与认知,例如目前已经能将照片中的狗跟猫做具体区隔,但在动态影片内容分析仍有进步空间,即便现行技术已经能在动态影片中分析寻找相同人物,或是追踪特定人物在影片中的行进方向,并且与多组影片行进方向做串接,却仍无法完整分析影片中的复杂动态行为,因此Google此次借由AVA数据分析学习人类互动模式,主要就是为了让人工智能系统能更理解人类自然互动行为。