训练史上最佳GAN用了512块TPU 一作自述:这不是算法进步 是算力进步

消息来源:baojiabao.com 作者: 发布时间:2024-04-26

铜灵 编译整理

量子位 出品 | 公众号 QbitAI

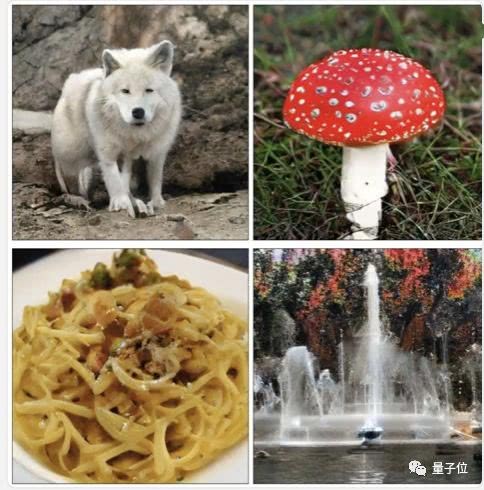

最近,一场“大GAN(BigGAN)”浪潮让机器学习界的行家沸腾了一次。看到这个生成图片质量足以以假乱真的神经网络,网友齐声称赞“算法好棒”。

这篇还在双盲审中的ICLR 19论文一作现身,实名反对这种看法。

在接受外媒FastCompany采访时,一作Andrew Brock表示,大GAN成功的关键,不在于算法的改进,而是计算力的进步。

计算力

大GAN出自论文Large Scale GAN Training for High Fidelity Natural Image Synthesis,除了能生成128×128小图之外,大GAN还能直接在256×256、512×512的ImageNet数据上训练,生成更让人信服的样本。

效果如此超脱凡GAN,不止是因为大GAN模型参数多,更是因为训练规模大。它的参数是前人的2-4倍,批次大小是前人的8倍。

“这些模型所需的主要不是算法的改进,而是计算力的进步。当你增加模型容量并增大每步所显示的图像数量时,你就会得到双重组合带来的效果。”论文一作Andrew Brock说。

换句话说,通过增加更多节点增加神经网络的复杂性,Brock能够创造出准确率更高的系统和模型纹理,然后将这些单独的纹理结合起来生成更大的形状,比如一只完整的小猫或者小狗。

方法不错,效果很好,两者之中,需要的是怎样的算力?

Brock说是512块谷歌TPU。

在这场实验中,Brock等人生成512像素图像,需要的是512块谷歌TPU,并且训练时间会持续24到48个小时。

光有TPU加持可能还不够,你还得找一个电量充足的地方。大致估算一下,如果每个TPU每个小时需要200瓦的电量,那么在Brock的512像素实验中,每个TPU将耗费2450到4915度电,相当于一个普通美国家庭大约半年内的用电量。

看来,普通人和机器学习高手的差距,可能不仅仅是几个算法之间的差距那么简单了……

别人家的实习生

虽然团队在9月末版的论文中没有署名,但能一口气用512块TPU用于研究,找遍全球也没有几家公司有这样的经济实力。

现在,团队终于公布了三位研究人员分别为Andrew Brock、谷歌DeepMind研究员Jeff Donahue和Karen Simonyan。

在刀光剑影的机器学习界有句土话:别人家的实习生,从未让我失望过。没错,大GAN团队的一作,就是一位实习生。

Brock目前还就读于赫瑞瓦特大学(Heriot-Watt University),量子位翻看了这位同学的推特,发现虽然还是学生,但已经被多方大牛关注著:

谷歌大牛Goodfellow、PyTorch之父Soumith Chintala、谷歌大脑东京网红研究员hardmaru、特斯拉AI负责人Andrej Karpathy、《纽约时报》资深记者Cade Metz,都已经成为Brock的粉丝……

传送门

最后,附论文地址:

https://arxiv.org/pdf/1809.11096.pdf

不过,要想复现这篇论文,可能难了点~

—完—

加入社群

量子位AI社群28群开始招募啦,欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“交流群”,获取入群方式;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进专业群请在量子位公众号(QbitAI)对话界面回复关键字“专业群”,获取入群方式。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

相关文章

中兴受美国制裁事件 被罚了20亿美元过程事件始末 中兴被制裁后公司现状

中兴受美国制裁事件 被罚了20亿美元过程事件始末 中兴被制裁后公司现状2023-11-02 22:12:46

B站怎么炸崩了哔哩哔哩服务器今日怎么又炸挂了?技术团队公开早先原因

B站怎么炸崩了哔哩哔哩服务器今日怎么又炸挂了?技术团队公开早先原因2023-03-06 19:05:55

苹果iPhoneXS/XR手机电池容量续航最强?答案揭晓

苹果iPhoneXS/XR手机电池容量续航最强?答案揭晓2023-02-19 15:09:54

华为荣耀两款机型起内讧:荣耀Play官方价格同价同配该如何选?

华为荣耀两款机型起内讧:荣耀Play官方价格同价同配该如何选?2023-02-17 23:21:27

google谷歌原生系统Pixel3 XL/4/5/6 pro手机价格:刘海屏设计顶配版曾卖6900元

google谷歌原生系统Pixel3 XL/4/5/6 pro手机价格:刘海屏设计顶配版曾卖6900元2023-02-17 18:58:09

科大讯飞同传同声翻译软件造假 浮夸不能只罚酒三杯

科大讯飞同传同声翻译软件造假 浮夸不能只罚酒三杯2023-02-17 18:46:15

华为mate20pro系列手机首发上市日期价格,屏幕和电池参数配置对比

华为mate20pro系列手机首发上市日期价格,屏幕和电池参数配置对比2023-02-17 18:42:49

小米MAX4手机上市日期首发价格 骁龙720打造大屏标准

小米MAX4手机上市日期首发价格 骁龙720打造大屏标准2023-02-17 18:37:22

武汉弘芯遣散!结局是总投资1280亿项目烂尾 光刻机抵押换钱

武汉弘芯遣散!结局是总投资1280亿项目烂尾 光刻机抵押换钱2023-02-16 15:53:18

谷歌GoogleDrive网云盘下载改名“GoogleOne” 容量提升价格优惠

谷歌GoogleDrive网云盘下载改名“GoogleOne” 容量提升价格优惠2023-02-16 13:34:45

巴斯夫将裁员6000人 众化工巨头裁员潮再度引发关注

巴斯夫将裁员6000人 众化工巨头裁员潮再度引发关注2023-02-13 16:49:06

人手不足 韵达快递客服回应大量包裹派送异常没有收到

人手不足 韵达快递客服回应大量包裹派送异常没有收到2023-02-07 15:25:20

资本微念与李子柒销声匿迹谁赢? 微念公司退出子柒文化股东

资本微念与李子柒销声匿迹谁赢? 微念公司退出子柒文化股东2023-02-02 09:24:38

三星GalaxyS8 S9 S10系统恢复出厂设置一直卡在正在检查更新怎么办

三星GalaxyS8 S9 S10系统恢复出厂设置一直卡在正在检查更新怎么办2023-01-24 10:10:02

华为Mate50 RS保时捷最新款顶级手机2022多少钱?1.2万元售价外观图片吊打iPhone14

华为Mate50 RS保时捷最新款顶级手机2022多少钱?1.2万元售价外观图片吊打iPhone142023-01-06 20:27:09

芯片常见的CPU芯片封装方式 QFP和QFN封装的区别?

芯片常见的CPU芯片封装方式 QFP和QFN封装的区别?2022-12-02 17:25:17

华为暂缓招聘停止社招了吗?官方回应来了

华为暂缓招聘停止社招了吗?官方回应来了2022-11-19 11:53:50

热血江湖手游:长枪铁甲 刚猛热血 正派枪客全攻略技能介绍大全

热血江湖手游:长枪铁甲 刚猛热血 正派枪客全攻略技能介绍大全2022-11-16 16:59:09

东京把玩了尼康微单相机Z7 尼康Z7现在卖多少钱?

东京把玩了尼康微单相机Z7 尼康Z7现在卖多少钱?2022-10-22 15:21:55

苹果iPhone手机灵动岛大热:安卓灵动岛App应用下载安装量超100万次

苹果iPhone手机灵动岛大热:安卓灵动岛App应用下载安装量超100万次2022-10-03 22:13:45